中国辩学我术大 Focal Loss for Dense Object Detection Facebook AI Research (FAIR) SA19006022胡彬

Focal Loss for Dense Object Detection Facebook AI Research (FAIR) SA19006022 胡彬

中国学我术大 论文简介 理论方案 实验结果

论文简介 理论方案 实验结果

中国绅学我术大草 论文简介 问题引入: 目前目标检测的框架一般分为两种:基于候选区域的two-stagel的检测框架(r-cnn系列),基于回归的 one-stage的检测框架(yolo、ssd系列),two-stage?效果好但是速度慢,one-stage速度快但是效果差。 为什么one-stagel的检测器准确率不高?作者给出的解释是由于正负样本不均衡的问题。样本中会存在 大量的easy examples,.且都是负样本(属于背景的样本)。这样,en masse easy negative examples:会对loss起主 要贡献作用,进而主导梯度的更新方向。网络无法学习有用的信息,无法对object进行准确分类。 (1)training is inefficient as most locations are easy negatives that contribute no useful learning signal; (2)en masse,the easy negatives can overwhelm training and lead to degenerate models

论文简介 问题引入: 目前目标检测的框架一般分为两种:基于候选区域的two-stage的检测框架(r-cnn系列),基于回归的 one-stage的检测框架(yolo、ssd系列),two-stage效果好但是速度慢,one-stage速度快但是效果差。 为什么one-stage的检测器准确率不高?作者给出的解释是由于正负样本不均衡的问题。样本中会存在 大量的easy examples,且都是负样本(属于背景的样本)。这样,en masse easy negative examples会对loss起主 要贡献作用,进而主导梯度的更新方向。网络无法学习有用的信息,无法对object进行准确分类。 (1) training is inefficient as most locations are easy negatives that contribute no useful learning signal; (2) en masse, the easy negatives can overwhelm training and lead to degenerate models

中国绅学我术大草 论文简介 负样本数量太大,占总的1oss的大部分,而且多是容易分类的,因此使得模型的优化方向并不是我们所 希望的那样。先前也有一些算法来处理类别不均衡的问题,比如OHEM(online hard example mining), OHEM算法虽然增加了错分类样本的权重,但是OHEM算法忽略了容易分类的样本。 针对类别不均衡问题,作者提出一种新的损失函数:focal loss,这个损失函数是在标准交叉熵损失基 础上修改得到的。这个函数可以通过减少易分类样本的权重,使得模型在训练时更专注于难分类的样本。 为了证明focal loss的有效性,作者设计了一个dense detector:RetinaNet,.并且在训练时采用focal loss训练。 实验证明RetinaNet不仅可以达到one-stage detector的速度,也能有two-stage detectorl的准确率

论文简介 负样本数量太大,占总的loss的大部分,而且多是容易分类的,因此使得模型的优化方向并不是我们所 希望的那样。先前也有一些算法来处理类别不均衡的问题,比如OHEM(online hard example mining), OHEM算法虽然增加了错分类样本的权重,但是OHEM算法忽略了容易分类的样本。 针对类别不均衡问题,作者提出一种新的损失函数:focal loss,这个损失函数是在标准交叉熵损失基 础上修改得到的。这个函数可以通过减少易分类样本的权重,使得模型在训练时更专注于难分类的样本。 为了证明focal loss的有效性,作者设计了一个dense detector:RetinaNet,并且在训练时采用focal loss训练。 实验证明RetinaNet不仅可以达到one-stage detector的速度,也能有two-stage detector的准确率

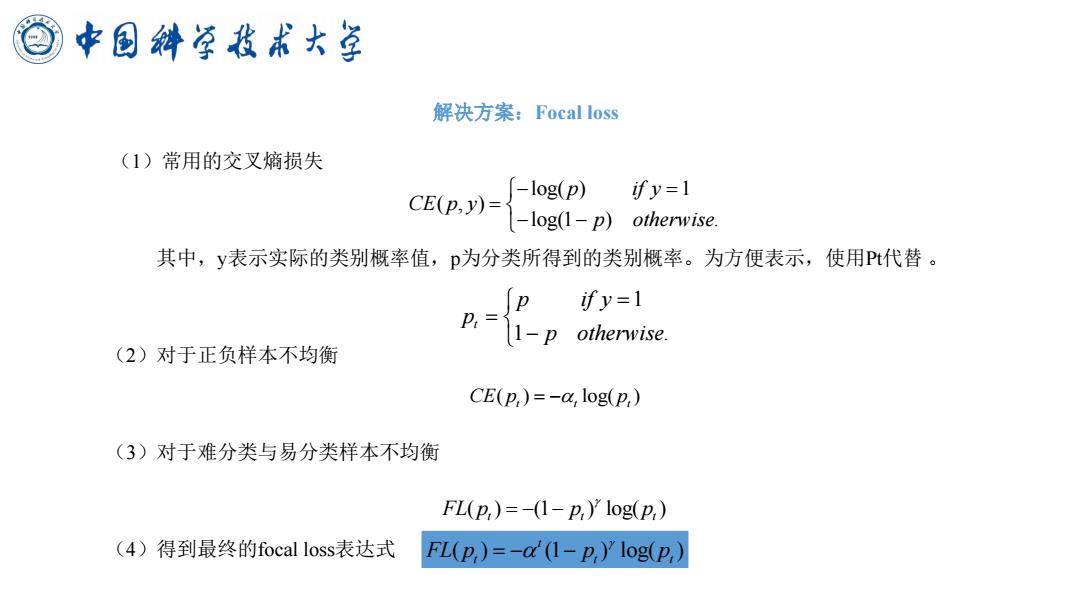

中国绅学我术大草 解决方案:Focal loss (1)常用的交叉熵损失 -log(p) CE(p,y)= ify=1 -log(1-p)otherwise 其中,y表示实际的类别概率值,p为分类所得到的类别概率。为方便表示,使用Pt代替。 ify=1 p,11-p otherwise. (2)对于正负样本不均衡 CE(p,)=-a,log(p,) (3)对于难分类与易分类样本不均衡 FL(p,)=-(1-2,)'log(p,) (4)得到最终的focal loss表达式 FL(p,)=-ad1-p,)'1og(P,)

解决方案:Focal loss (1)常用的交叉熵损失 其中,y表示实际的类别概率值,p为分类所得到的类别概率。为方便表示,使用Pt代替 。 (2)对于正负样本不均衡 (3)对于难分类与易分类样本不均衡 (4)得到最终的focal loss表达式 log( ) 1 ( , ) log(1 ) . p if y CE p y p otherwise − = = − − 1 1 . t p if y p p otherwise = = − ( ) log( ) CE p p t t t = − ( ) (1 ) log( ) FL p p p t t t = − − ( ) (1 ) log( ) t FL p p p t t t = − −