点说明 ÷计算自信息量时要注意有关事件发生概率的计算; 自信息量的单位取决于对数的底; s底为2,单位为“比特(bit,binary unit) ” s底为e,单位为“奈特(nat,nature unit) 6底为l0,单位为“哈特(hat,Hartley)” 6根据换底公式得: l10g。X= logX log a 1 nat=1.44bit,1 hat=3.32 bit; 般计算都采用以“2”为底的对数,为了书写简洁 常把底数“2”略去不写

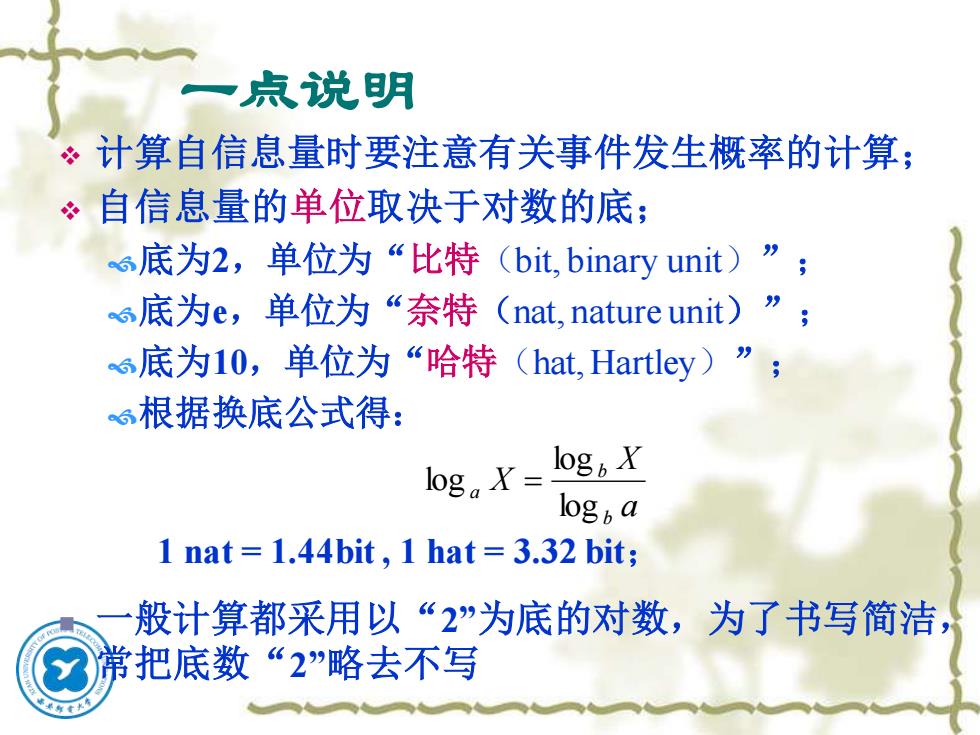

一点说明 ❖ 计算自信息量时要注意有关事件发生概率的计算; ❖ 自信息量的单位取决于对数的底; 底为2,单位为“比特(bit, binary unit)”; 底为e,单位为“奈特(nat, nature unit)”; 底为10,单位为“哈特(hat, Hartley)”; 根据换底公式得: a X X b b a log log log = ◼ 一般计算都采用以“2”为底的对数,为了书写简洁, 常把底数“2”略去不写 1 nat = 1.44bit , 1 hat = 3.32 bit;

上式中的称为随机事件的自信息量。它的单位与所采用的对数的底有关。 若取a=2,则自信息量的单位为bit;若取a=e,则其单位为nat;若取a=10, 则其单位为det。 对于一个以等概率出现的二进制码元(0,1),它所包含的信息量为: 1(0)=I(1)=-log:bit=log,2bit=l(bit) 若有个m位的二进制数,其自信息量为:1=-lg:六bi=1e,2"b=mb 即需要mbit信息来指明这样的二进制数。 若有两个消息x,y同时出现,则其自信息量定义为:I(y)=-lgPy) p(y)为联合概率。 若x与y相互独立,即pxy)=px)Py)则有 I(x;y)=1(x)+1(y 若x与y的出现不是相互独立的,而是有联系的,此时,要用条件概率来表示 即在事件y出现的条件下,事件x发生的条件概率,其条件自信息量定义为: I(x;y)=-loga p(xy)

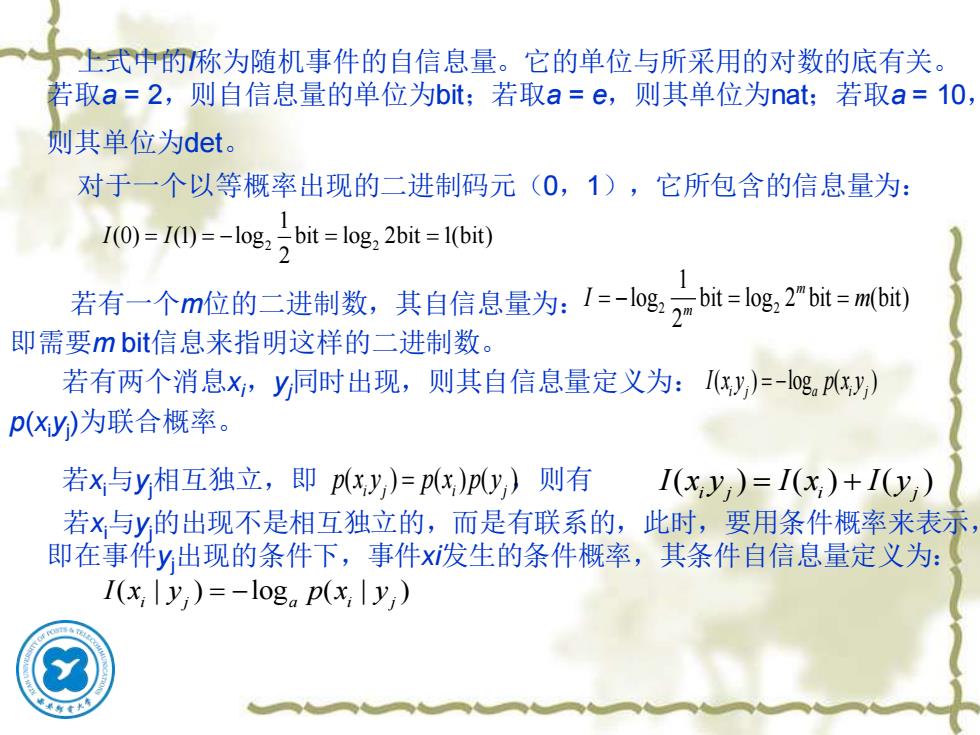

上式中的I称为随机事件的自信息量。它的单位与所采用的对数的底有关。 若取a = 2,则自信息量的单位为bit;若取a = e,则其单位为nat;若取a = 10, 则其单位为det。 对于一个以等概率出现的二进制码元(0,1),它所包含的信息量为: 若有一个m位的二进制数,其自信息量为: 即需要m bit信息来指明这样的二进制数。 若有两个消息xi,yj同时出现,则其自信息量定义为: p(xiyj )为联合概率。 若xi与yj相互独立,即 ,则有 若xi与yj的出现不是相互独立的,而是有联系的,此时,要用条件概率来表示, 即在事件yj出现的条件下,事件xi发生的条件概率,其条件自信息量定义为: 2 2 1 (0) (1) log bit log 2bit 1(bit) 2 I I = = − = = 2 2 1 log bit log 2 bit (bit) 2 m m I m = − = = ( ) log ( ) i j a i j I x y p x y = − ( ) ( ) ( ) i j i j p x y p x p y ( ) ( ) ( ) i j i j = I x y I x I y = + ( | ) log ( | ) i j a i j I x y p x y = −

例题2-1英文字母中“a”出现的概率为0.063,“c”出现的概率为0.023,“e” 出现的概率为0.105,分别计算它们的自信息量。 解:由自信息量的定义式,有 1(a)=-l0g2 0.063bit=3.96bit I(c)=-log,0.023bit 5.44bit I(e)=-log2 0.105bit =3.25bit 例题2-2将二信息分别编码为A和B进行传送,在接收端,A被误收作B的概 率为0.02;而B被误收作A的概率为0.01,A与B传送的频繁程度为2:1。若 接收端收到的是A,计算原发信息是A的条件自信息量。 解:设U0表示发送A,U1表示发送B;V0表示接收A,V1表示接收B。 由题意知: p(Uo)= 2-3 )-3 p1U)=0.02 p(Vo1Uo)=0.98 p%IU)=0.99 p(V1U)=0.01

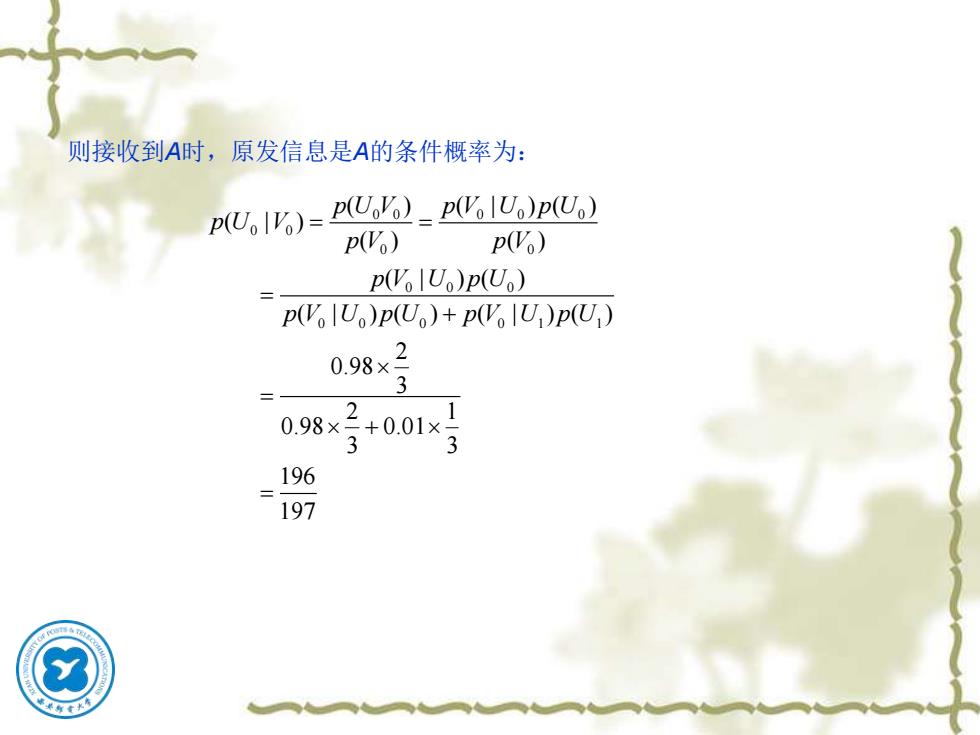

例题2-1 英文字母中“a”出现的概率为0.063,“c”出现的概率为0.023,“e” 出 现的概率为0.105,分别计算它们的自信息量。 解: 由自信息量的定义式,有 例题2-2 将二信息分别编码为A和B进行传送,在接收端,A被误收作B的概 率为0.02;而B被误收作A的概率为0.01,A与B传送的频繁程度为2:1。若 接收端收到的是A,计算原发信息是A的条件自信息量。 解:设U0表示发送A,U1表示发送B;V0表示接收A,V1表示接收B。 由题意知: 2 I a( ) log 0.063bit 3.96bit = − = 2 I c( ) log 0.023bit 5.44bit = − = 2 I e( ) log 0.105bit 3.25bit = − = 0 2 ( ) 3 p U = 1 1 ( ) 3 p U = 1 0 p V U ( | ) 0.02 = 0 0 p V U ( | ) 0.98 = 0 1 p V U ( | ) 0.01 = 1 1 p V U ( | ) 0.99 = , , ,

则接收到A时,原发信息是A的条件概率为: p(U)=(o) p(VolU)p(Uo) p(Vo) p(Vo) p(VolU)p(Uo) pVU)p(U)+pVU)p(U) 0.98×2 098×2+0.01×3 2 3 196 197

则接收到A时,原发信息是A的条件概率为: 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 1 1 ( ) ( | ) ( ) ( | ) ( ) ( ) ( | ) ( ) ( | ) ( ) ( | ) ( ) 2 0.98 3 2 1 0.98 0.01 3 3 196 197 p U V p V U p U p U V p V p V p V U p U p V U p U p V U p U = = = + = + =

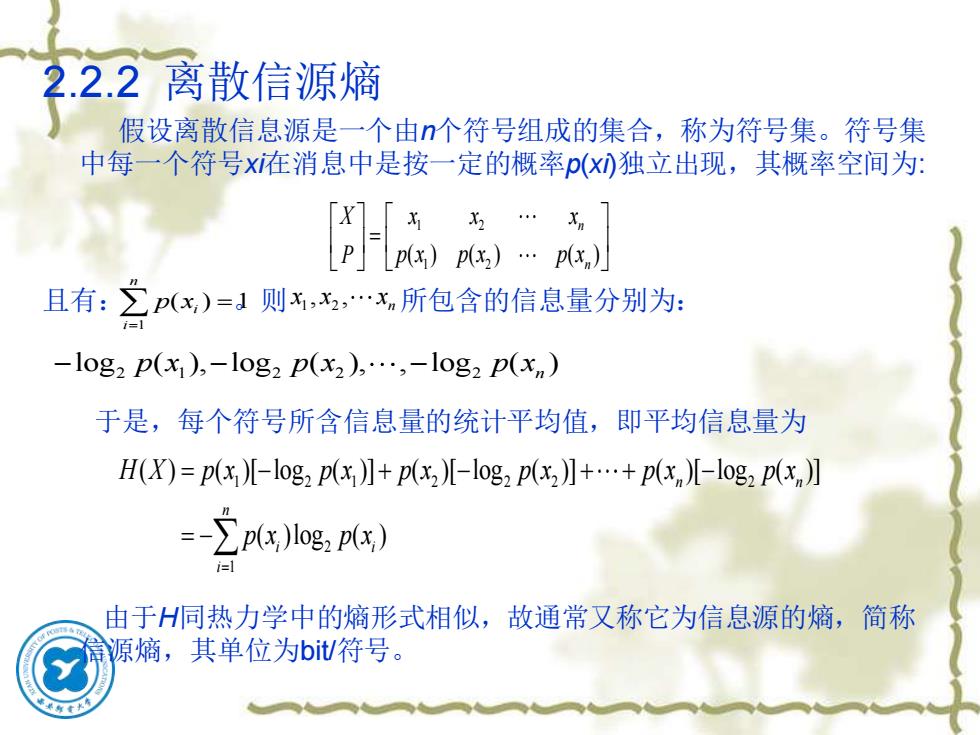

2.2.2离散信源熵 假设离散信息源是一个由个符号组成的集合,称为符号集。符号集 中每一个符号x在消息中是按一定的概率p()独立出现,其概率空间为: X 且有:∑p(x)=1则,x,.x所包含的信息量分别为: -10g2 p(x),-10g2 p(x2),.,-10g2 p(x) 于是,每个符号所含信息量的统计平均值,即平均信息量为 H(X)=p(x儿-log2px】+p(x2儿-log2px2】+.+pxn)[-log2p(xn】 =-∑pPx)log,px) i=1 由于H同热力学中的熵形式相似,故通常又称它为信息源的熵,简称 匍源熵,其单位为bit/符号

2.2.2 离散信源熵 假设离散信息源是一个由n个符号组成的集合,称为符号集。符号集 中每一个符号xi在消息中是按一定的概率p(xi)独立出现,其概率空间为: 且有: 。则 所包含的信息量分别为: 于是,每个符号所含信息量的统计平均值,即平均信息量为 由于H同热力学中的熵形式相似,故通常又称它为信息源的熵,简称 信源熵,其单位为bit/符号。 1 2 1 2 ( ) ( ) ( ) n n X x x x P p x p x p x = 1 ( ) 1 n i i p x = = 1 2 , , n x x x 2 1 2 2 2 log ( ), log ( ), , log ( ) − − − p x p x p xn 1 2 1 2 2 2 2 2 1 ( ) ( )[ log ( )] ( )[ log ( )] ( )[ log ( )] ( )log ( ) n n n i i i H X p x p x p x p x p x p x p x p x = = − + − + + − = −